Deepfake’i to technologia, która wykorzystuje sztuczną inteligencję do tworzenia realistycznych, ale fałszywych obrazów i dźwięków. Termin ten powstał z połączenia słów „deep learning” (głębokie uczenie) oraz „fake” (fałszywy). Deepfake’i mogą przybierać różne formy, od zmiany twarzy w filmach po generowanie całkowicie nowych treści audio, które naśladują głosy znanych osób.

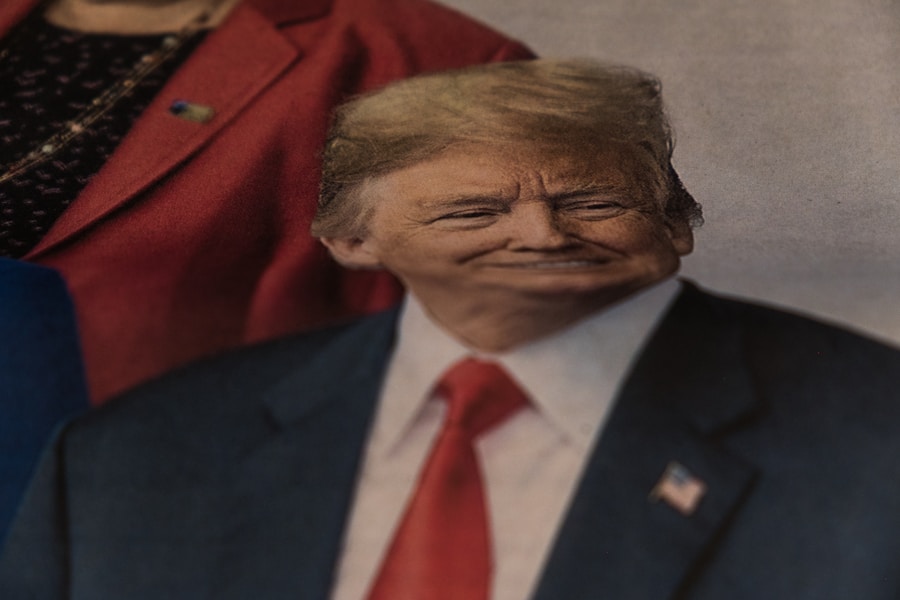

W ostatnich latach technologia ta zyskała na popularności, a jej zastosowania obejmują zarówno rozrywkę, jak i bardziej kontrowersyjne obszary, takie jak dezinformacja czy oszustwa. W praktyce deepfake’i mogą być wykorzystywane do tworzenia filmów, w których znane osobistości wydają się mówić lub robić coś, czego w rzeczywistości nie zrobiły. Przykładem może być film, w którym polityk wygłasza kontrowersyjne oświadczenia, co może prowadzić do poważnych konsekwencji społecznych i politycznych.

Technologia ta staje się coraz bardziej dostępna, co rodzi pytania o etykę jej użycia oraz potencjalne zagrożenia dla prywatności i bezpieczeństwa.

Jak działają deepfake’i?

Deepfake’i opierają się na zaawansowanych algorytmach uczenia maszynowego, w szczególności na sieciach neuronowych. Najczęściej wykorzystywaną metodą jest tzw. Generative Adversarial Network (GAN), która składa się z dwóch sieci: generatora i dyskryminatora.

Generator tworzy nowe obrazy lub dźwięki, podczas gdy dyskryminator ocenia, czy są one autentyczne, czy fałszywe. Obie sieci uczą się nawzajem, co prowadzi do coraz bardziej realistycznych wyników. Proces tworzenia deepfake’a zaczyna się od zbierania danych – zdjęć lub nagrań wideo osoby, której twarz ma być użyta.

Następnie algorytmy analizują te dane, aby zrozumieć cechy charakterystyczne twarzy, takie jak mimika, kąt nachylenia czy oświetlenie.

W przypadku deepfake’ów audio proces jest podobny; algorytmy uczą się na podstawie nagrań głosu, aby naśladować sposób mówienia danej osoby.

Dlaczego deepfake’i są problemem?

Deepfake’i stanowią poważne zagrożenie dla społeczeństwa z kilku powodów. Po pierwsze, mogą być wykorzystywane do szerzenia dezinformacji. W erze informacji, w której łatwo jest manipulować treściami wideo i audio, deepfake’i mogą wprowadzać w błąd opinię publiczną i wpływać na wyniki wyborów czy decyzje polityczne.

Przykłady z przeszłości pokazują, że fałszywe filmy mogą wywołać protesty lub panikę społeczną. Po drugie, deepfake’i mogą naruszać prywatność jednostek. Osoby publiczne, takie jak aktorzy czy politycy, mogą stać się ofiarami oszustw mających na celu ich kompromitację.

Wiele przypadków dotyczyło tworzenia pornograficznych materiałów z wykorzystaniem twarzy znanych osób bez ich zgody. Tego rodzaju działania nie tylko szkodzą reputacji ofiar, ale także mogą prowadzić do poważnych konsekwencji prawnych.

Jak rozpoznać deepfake?

Rozpoznawanie deepfake’ów staje się coraz trudniejsze, ponieważ technologia ta rozwija się w szybkim tempie. Niemniej jednak istnieją pewne cechy, które mogą pomóc w identyfikacji fałszywych treści. Po pierwsze, warto zwrócić uwagę na nienaturalne ruchy twarzy lub ciała.

Deepfake’i często mają problemy z odwzorowaniem subtelnych niuansów mimiki, co może prowadzić do nienaturalnego wyglądu postaci. Kolejnym sygnałem ostrzegawczym są problemy z synchronizacją dźwięku i obrazu. W przypadku deepfake’ów audio może występować opóźnienie lub brak zgodności między tym, co mówi osoba na ekranie a tym, co słyszymy.

Dodatkowo warto zwrócić uwagę na oświetlenie i cienie – w wielu przypadkach deepfake’i nie potrafią realistycznie odwzorować tych elementów, co może zdradzić ich fałszywe pochodzenie.

Narzędzia do wykrywania deepfake’ów

W odpowiedzi na rosnące zagrożenie związane z deepfake’ami powstało wiele narzędzi i technologii mających na celu ich wykrywanie.

Narzędzia te uczą się na podstawie dużych zbiorów danych, aby identyfikować cechy charakterystyczne dla deepfake’ów.

Przykładem takiego narzędzia jest Deepware Scanner, które analizuje filmy pod kątem obecności deepfake’ów i ocenia ich prawdopodobieństwo bycia fałszywymi. Inne rozwiązania to np. Sensity AI czy Amber Video, które również wykorzystują sztuczną inteligencję do detekcji manipulacji wideo.

W miarę jak technologia deepfake’ów staje się coraz bardziej zaawansowana, narzędzia do ich wykrywania muszą również ewoluować, aby skutecznie przeciwdziałać nowym metodom oszustwa.

Jak unikać pułapek związanych z deepfake’ami?

Aby unikać pułapek związanych z deepfake’ami, kluczowe jest rozwijanie umiejętności krytycznego myślenia oraz umiejętności analizy informacji. Użytkownicy internetu powinni być świadomi potencjalnych zagrożeń związanych z treściami wideo i audio oraz nauczyć się kwestionować źródła informacji. Ważne jest również sprawdzanie wiarygodności materiałów przed ich udostępnieniem lub podzieleniem się nimi z innymi.

Edukacja społeczeństwa na temat deepfake’ów jest niezbędna do minimalizowania ich wpływu na życie codzienne. Szkoły i instytucje edukacyjne powinny wprowadzać programy nauczania dotyczące mediów cyfrowych oraz umiejętności rozpoznawania fałszywych treści. Ponadto warto korzystać z narzędzi do weryfikacji faktów oraz platform informacyjnych, które oferują rzetelne analizy i oceny wiarygodności materiałów.

Jakie są konsekwencje deepfake’ów dla społeczeństwa?

Konsekwencje związane z rozwojem technologii deepfake są wieloaspektowe i mogą mieć dalekosiężne skutki dla społeczeństwa. Jednym z najpoważniejszych problemów jest erozja zaufania do mediów oraz informacji w ogóle. W miarę jak coraz więcej osób staje się świadomych istnienia deepfake’ów, może to prowadzić do ogólnego sceptycyzmu wobec wszelkich treści wizualnych i dźwiękowych.

Taki stan rzeczy może utrudniać komunikację społeczną oraz wpływać na procesy demokratyczne. Dodatkowo deepfake’i mogą przyczyniać się do wzrostu przestępczości internetowej oraz oszustw finansowych. Osoby wykorzystujące tę technologię mogą tworzyć fałszywe tożsamości lub podszywać się pod innych ludzi w celu wyłudzenia pieniędzy lub informacji osobistych.

W rezultacie rośnie potrzeba ochrony danych osobowych oraz rozwijania systemów zabezpieczeń przed tego rodzaju zagrożeniami.

Co robią organizacje i instytucje, aby zwalczać deepfake?

W odpowiedzi na rosnące zagrożenie związane z deepfake’ami wiele organizacji oraz instytucji podejmuje działania mające na celu ich zwalczanie. Rządy niektórych krajów zaczynają wprowadzać regulacje prawne dotyczące użycia technologii deepfake oraz kar za jej nadużywanie. Przykładem może być Kalifornia, gdzie uchwalono prawo penalizujące tworzenie deepfake’ów w celu oszustwa lub szkodzenia innym osobom.

Ponadto organizacje zajmujące się bezpieczeństwem cyfrowym oraz badacze pracują nad rozwojem narzędzi do wykrywania deepfake’ów oraz metod ich neutralizacji. Współpraca między sektorem prywatnym a publicznym staje się kluczowa w walce z tym problemem. Wiele firm technologicznych inwestuje w badania nad sztuczną inteligencją oraz rozwija algorytmy mające na celu identyfikację fałszywych treści.

W miarę jak technologia deepfake będzie się rozwijać, konieczne będzie dalsze monitorowanie jej wpływu na społeczeństwo oraz podejmowanie działań mających na celu ochronę jednostek przed jej negatywnymi skutkami.